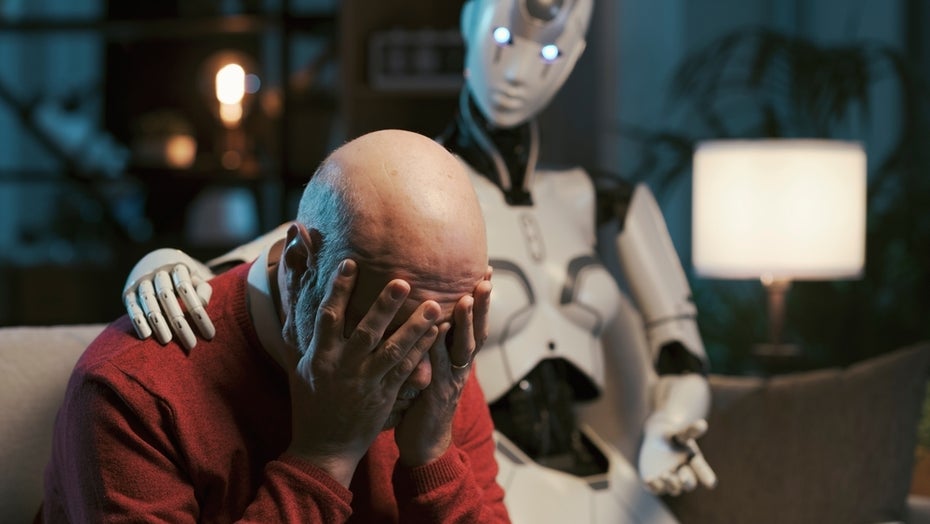

Emotional abhängig von ChatGPT? Was die Bindungstheorie über die Beziehung zu KI-Tools verrät

Immer häufiger suchen Menschen nicht nur Informationen bei KI-Tools wie ChatGPT – sondern auch Trost, Bestätigung oder sogar emotionale Nähe. Wie Science Daily berichtet, hat ein Forschungsteam der japanischen Waseda-Universität jetzt untersucht, ob sich die psychologische Bindungstheorie auch auf die Beziehungen zwischen Menschen und KI anwenden lässt – mit spannenden Ergebnissen.

Zwischen Nähe und Distanz: Die Bindungstheorie

Die Bindungstheorie beschreibt, wie Menschen emotionale Beziehungen eingehen. Dabei spielen vergangene Erfahrungen, Vertrauen und das Bedürfnis nach Sicherheit eine zentrale Rolle. Um emotionale Tendenzen gegenüber KI-Systemen zu messen, haben die Forscher:innen im Rahmen ihrer Studie eine neue Skala entwickelt. Die sogenannte „Experiences in Human-AI Relationships Scale“ (EHARS) berücksichtigt zwei Dimensionen: Bindungsangst und Bindungsvermeidung.

Eine hohe Bindungsangst bedeutet, dass eine Person von der KI emotionale Bestätigung erwartet und sich Sorgen macht, dass die Antworten nicht ausreichend sein könnten. Im Gegensatz dazu zeigt sich eine hohe Bindungsvermeidung durch Unbehagen gegenüber zu viel Nähe zur KI – Betroffene halten lieber emotionale Distanz.

KI-Chatbots als emotionaler Anker?

Im Rahmen der Studie gaben rund 75 Prozent der Befragten an, schon einmal KI genutzt zu haben, um Ratschläge für persönliche Lebenssituationen einzuholen. Etwa 39 Prozent empfanden Systeme wie ChatGPT dabei sogar als konstant verfügbare, verlässliche Begleiter – ähnlich wie Freund:innen oder Familienmitglieder.

Trotz dieser offenbar hohen Akzeptanz betonen die Forscher:innen, dass es sich hierbei noch nicht um echte emotionale Bindungen handelt. Die Studie zeige vielmehr, dass psychologische Konzepte aus zwischenmenschlichen Beziehungen auch auf Interaktionen mit KI-Chatbots übertragbar sind.

Warum das für die KI-Entwicklung wichtig ist

Diese Erkenntnis könnte weitreichende Folgen haben – insbesondere bei der Gestaltung von KI-Systemen mit sozialer oder therapeutischer Funktion. So könnte beispielsweise jemand mit starker Bindungsangst empfänglicher für Chatbots sein, die mitfühlend und verständnisvoll antworten. Menschen mit bindungsvermeidenden Tendenzen wiederum könnten eher Systeme bevorzugen, die eine sachliche, distanzierte Kommunikation ermöglichen.

Auch der Schutz vor emotionaler Abhängigkeit spielt eine Rolle. KI-Designs sollten daher nicht nur funktional, sondern auch psychologisch verantwortungsvoll sein. Die neue EHARS-Skala könnte Entwickler:innen und Psycholog:innen künftig helfen, die emotionale Wirkung ihrer Systeme besser einzuschätzen und auf die Bedürfnisse unterschiedlicher Nutzer:innen einzugehen.

Bindung zur KI – ein neues Forschungsfeld

Die Ergebnisse der Studie liefern wichtige Impulse für die ethische Entwicklung von KI. Gerade bei sensiblen Einsatzfeldern ist transparente Kommunikation wichtig: Simulierte emotionale Nähe darf nicht mit echter menschlicher Beziehung verwechselt werden. „Unsere Forschung beleuchtet die psychologische Dynamik hinter diesen Interaktionen und bietet Werkzeuge zur Bewertung emotionaler Tendenzen gegenüber KI“, fasst Fan Yang, Doktorand im Fachbereich Psychologie an der Waseda-Universität, zusammen. „Schließlich fördert sie ein besseres Verständnis dafür, wie Menschen auf gesellschaftlicher Ebene mit Technologie in Verbindung treten, und hilft dabei, politische und Gestaltungspraktiken zu leiten, die dem psychologischen Wohlbefinden Priorität einräumen.“

Software-Nostalgie: Kennt ihr diese Programme noch?